In un recente articolo sul blog di Planetek, Vincenzo Barbieri parla dei nuovi modelli di business possibili oggi grazie alla straordinaria disponibilità di immagini satellitari free e open.

In un recente articolo sul blog di Planetek, Vincenzo Barbieri parla dei nuovi modelli di business possibili oggi grazie alla straordinaria disponibilità di immagini satellitari free e open.Il titolo del post fa riferimento ai cosiddetti “disruptive business models”, quelli che cambiano le regole del gioco. Un esempio è quello del passaggio dalla vendita di un prodotto alla vendita di servizi su abbonamento (subscription). Questo modello di business è dirompente perché, prendendo un prodotto o servizio che veniva tradizionalmente acquistato ad hoc, lo rende disponibile in maniera continua e ripetuta nel tempo, ma soprattutto adattando il prodotto ai gusti e le preferenze del cliente. Si crea in questo modo il cosiddetto lock-in, una fidelizzazione che genera valore grazie al canone di abbonamento pagato dall’utente per l'accesso continuo - e tipicamente a basso costo - al prodotto. Basti pensare, per esempio, a cos'è cambiato in pochi anni con il passaggio dal noleggio delle videocassette di Blockbuster alla fruizione di film e serie TV disponibili in abbonamento con Netflix.

Gli ingredienti perfetti

Questa la ricetta proposta da Vincenzo per innescare un modello commerciale di questo tipo, grazie ai dati satellitari open:Ricetta: Prendiamo un’immagine satellitare ogni 6 giorni, aggiungiamo una base cartografica e un pizzico di dati ancillari (q.b.), tutto rigorosamente disponibile in modalità open data. Facciamo girare gli algoritmi di elaborazione e restituiamo i risultati sotto forma di mappe, indicatori e report. Tutto in ambiente Cloud accessibile in abbonamento.Con questa ricetta abbiamo cucinato non un solo piatto, bensì le portate di un intero banchetto: la nostra nuova piattaforma su Cloud per erogare servizi applicativi, basati su dati geospaziali open, per il monitoraggio di fenomeni naturali o artificiali sul nostro pianeta.

Abbiamo dato alla piattaforma il nome Rheticus®, in onore di Retico, l’unico allievo di Niccolò Copernico. Tanto per sottolineare lo stretto legame con il programma europeo Copernicus, nell’ambito del quale la Commissione Europea mette a disposizione dati satellitari e non solo, gratuitamente e con licenze d’uso open.

Come si può già vedere dal portale web che dà accesso ai prodotti in abbonamento, su www.rheticus.eu, i servizi di monitoraggio previsti spaziano dall'analisi della morfologia terrestre, della vegetazione e delle infrastrutture, alla sorveglianza degli ambienti marini e costieri, con finalità di controllo degli aspetti di tutela ambientale e produttivi.

Information as a Service

L'idea di fondo, anche nel caso di Rheticus, è quella di superare l'approccio legato alla produzione di mappe o database geografici più o meno complessi, ma che sono prodotti geoinformativi "statici": prodotti, appunto, estremamente validi ed importanti, che però ci raccontano quella che è la situazione oggi - o più spesso, quella che era la situazione ieri o quando il dato per estrarre l'informazione è stato acquisito. Invece, con una piattaforma su Cloud che accede continuamente ad una fonte di dati sempre aggiornata, che li processa, ed estrae continuamente informazioni aggiornate, sono certo di contare su un servizio che mi dà delle informazioni su ciò che accade oggi, sul mio territorio, ed analizzando i trend posso fare previsioni più attendibili su ciò che sarà domani.

Invece, con una piattaforma su Cloud che accede continuamente ad una fonte di dati sempre aggiornata, che li processa, ed estrae continuamente informazioni aggiornate, sono certo di contare su un servizio che mi dà delle informazioni su ciò che accade oggi, sul mio territorio, ed analizzando i trend posso fare previsioni più attendibili su ciò che sarà domani.Passo così, dalla fruizione di un prodotto, alla fruizione continua di un servizio informativo: è quella che chiamiamo Information as a Service.

Parliamone...

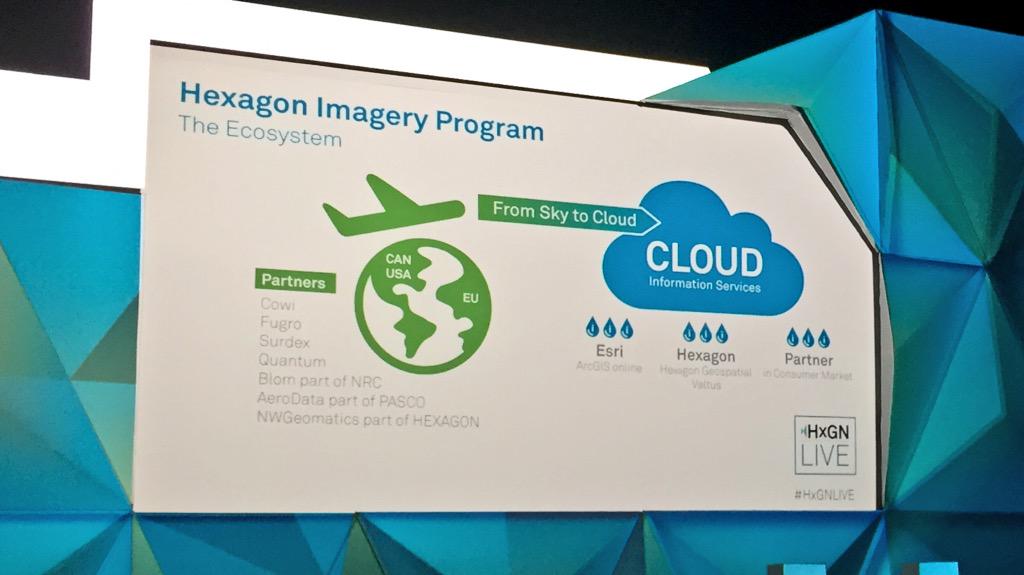

Modelli di business disruptive, open data satellitari, piattaforme cloud, servizi di monitoraggio degli spostamenti superficiali del terreno o delle aree percorse da incendio: di tutto questo parlerò in varie occasioni, nelle prossime due settimane, che prevedono un impegnativo e ricco calendario di appuntamenti:- Mercoledì 15 a Los Angeles, nel contesto della prestigiosa conferenza internazionale HxGN Live 2016, racconterò in che modo i servizi di monitoraggio offerti da Rheticus possono essere valorizzati, su scala globale, grazie all’integrazione con la piattaforma Cloud di Hexagon Geospatial Smart M.App. Le informazioni generate dalle catene di processing di Rheticus, fruite attraverso i cruscotti interattivi e le mappe dinamiche della piattaforma Smart M.App, cambiano radicalmente l’esperienza dell’utente. Che siano professionisti esperti, o decisori interessati soltanto a comprendere situazioni e tendenze, gli utenti possono approcciarsi oggi ad una modalità completamente nuova di fruizione dell’informazione geografica.

Sono stato invitato quindi a Los Angeles da Hexagon Geospatial, che mi ha dedicato un'intera Breackout Session, per presentare due esempi di trasformazione di modelli di business, dalla vendita di prodotti tradizionali all’erogazione di servizi di monitoraggio in abbonamento.

Uno è relativo alla perimetrazione delle aree incendiate nelle foreste: il nostro prodotto software Imagine Fire Mapper, valorizzato in una piattaforma Cloud come Smart M.App, permette di erogare servizi di analisi dei cambiamenti e di sorveglianza contro attività illegali.

Il secondo è relativo al nostro prodotto per il monitoraggio degli spostamenti superficiali del terreno: i servizi accessibili grazie a Rheticus® Displacement, una volta integrati nella piattaforma Smart M.App e venduti attraverso il marketplace di Hexagon Geospatial, ci consentono di raggiungere utenti in ogni parte del globo. - Lunedì 20 a Roma, nella sessione plenaria della 4° conferenza OpenGeoData (ed

in pieno jet lag...), avrò il piacere di confrontarmi con alcuni cari amici opendatari ed altri colleghi sul tema delle comunità che danno valore ai dati geografici aperti. Il mio intervento verterà naturalmente sulle comunità di utenti e aziende dei dati satellitari open, su come aziende e cittadini possono creare valore con questi dati, e su come questo valore possa essere misurato in termini economici.

L’altro giorno abbiamo anche scoperto, con grande soddisfazione e orgoglio, che Planetek Italia riceverà in quell’occasione il riconoscimento "Applicazioni 2016 di OpenGeoData Italia" proprio grazie al contributo innovativo della piattaforma Rheticus®. - Nel pomeriggio di lunedì 20 interverrò poi nella sessione “Usi e consumi dei dati satellitari” per discutere proprio dei nuovi servizi in cloud per i big data satellitari e dei nuovi modelli di business che questi servizi possono innescare.

- Martedì 21, sempre a Roma, abbiamo invece organizzato il workshop di presentazione delle

novità del Power Portfolio 2016 di Hexagon Geospatial: sarà l’occasione per approfondire carattaristiche, vantaggi e benefici della piattaforma Smart M.App e delle opportunità offerte dal marketplace globale di Hexagon per chi vuole realizzare e vendere servizi su Cloud che sfruttano dati e informazioni geospaziali. Delle Smart M.App di Hexagon Geospatial parlerà anche Vincenzo Barbieri, nel pomeriggio di martedì 21, alla conferenza LandCity, nella sessione tecnica “Cruscotti e Città intelligenti”: vedremo quali vantaggi offrono le dashboard interattive per offrire servizi di comunicazione dinamici nell’ambito dell’infomobilità, della pianificazione urbana e della tutela ambientale.

- Mercoledì 22 ho poi il privilegio di essere stato invitato alla Dodicesima Conferenza Nazionale di Statistica dell’ISTAT, dove ancora una volta, nella sessione “I vantaggi dall’uso degli Open data”, parlerò degli opendata satellitari per la conoscenza del territorio, e dei possibili utilizzi per il calcolo e l'aggiornamento di indicatori geo-statistici.